Dalam dunia machine learning, evaluasi model performance merupakan langkah penting untuk memastikan model yang kita bangun dapat bekerja sesuai harapan. Salah satu metode evaluasi yang sering digunakan dalam task klasifikasi adalah confusion matrix. Namun, apa itu confusion matrix dan bagaimana cara membacanya? Artikel ini akan membahas dasar-dasar confusion matrix serta cara menggunakannya untuk mengevaluasi model.

Apa itu Confusion Matrix?

Confusion matrix adalah tabel yang digunakan untuk menggambarkan kinerja model klasifikasi dengan membandingkan predicted values dengan actual values. Matriks ini membantu kita memahami di mana model kita berhasil dan di mana model membuat kesalahan.

Agar lebih jelas, mari kita terapkan confusion matrix pada suatu contoh kasus. Bayangkan Kita sedang membuat model machine learning untuk memprediksi apakah seorang pasien memiliki penyakit tertentu berdasarkan hasil pemeriksaan medis, masing-masing label dapat diartikan sebagai berikut:

- True Positive (TP): model memprediksi hasilnya positif dan itu benar, dengan kata lain model memprediksi pasien tersebut memiliki penyakit medis dan pada kenyataannya pasien tersebut memang memiliki penyakit medis

- True Negative (TN): model memprediksi hasilnya negatif dan itu benar, dengan kata lain model memprediksi pasien tersebut tidak memiliki penyakit medis dan pada kenyataannya pasien tersebut memang tidak memiliki penyakit medis

- False Positive (FP) / type I error: model memprediksi hasilnya positf dan itu salah, dengan kata lain model memprediksi pasien tersebut memiliki penyakit medis tapi pada kenyataannya pasien tidak memiliki penyakit medis

- False Negative (FN) / type II error: model memprediksi hasilnya negatif dan itu salah, dengan kata lain model memprediksi pasien tersebut tidak memiliki penyakit medis tapi pada kenyataannya pasien memiliki penyakit medis

Menghitung Evaluation Metrics

Dengan menggunakan confusion matrix, kita dapat menghitung berbagai evaluation metrics seperti:

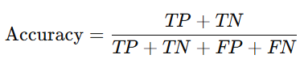

Accuracy

Mengukur proporsi prediksi yang benar terhadap semua data (Mengukur seberapa sering model memberikan prediksi yang benar).

Precision

Mengukur proporsi prediksi positif yang benar-benar positif (Mengukur seberapa banyak prediksi positif yang benar).

Recall

Mengukur seberapa baik model dalam mendeteksi data positif (Mengukur seberapa baik model mendeteksi pasien yang benar-benar sakit).

F1-Score

Merupakan rata-rata harmonis dari precision dan recall, yang berguna saat terdapat ketidakseimbangan data

Selanjutnya kita akan mencoba penerapan evaluation metrics ini pada contoh kasus di atas. Asumsikan bahwa jumlah dataset adalah 100 pasien, model memberikan prediksi apakah pasien memiliki penyakit (Positif) atau tidak (Negatif), label actual menunjukkan kondisi kesehatan pasien yang sesungguhnya.

Setelah menjalankan model kita mendapatkan hasil sebagai berikut:

- True Positive (TP): 50 (Model benar memprediksi pasien sakit).

- True Negative (TN): 35 (Model benar memprediksi pasien sehat).

- False Positive (FP): 5 (Model salah memprediksi pasien sakit, padahal sehat).

- False Negative (FN): 10 (Model salah memprediksi pasien sehat, padahal sakit).

Berdasarkan confusion matrix tersebut kita mendapatkan metrics:

- Accuracy: (50 + 35) : (50 + 10 + 5 + 35) = 0.85 (85%)

- Precision: (50) : (50 + 5) = 0.91 (91%)

- Recall: (50) : (50 + 10) = 0.83 (83%)

- F1-Score: 2 x ((0.91×0.83) : (0.91+0.83)) = 0.87 (87%)

Sehingga dapat disimpulkan bahwa:

- Model memiliki akurasi 85%, artinya 85 dari 100 prediksi adalah benar.

- Presisi 91% menunjukkan bahwa sebagian besar prediksi positif (sakit) benar.

- Recall 83% menunjukkan bahwa model mampu mendeteksi pasien yang sakit dengan cukup baik, tetapi ada beberapa pasien sakit yang terlewatkan.

- F1-Score 87% menunjukkan keseimbangan antara presisi dan recall.

Dalam kasus ini, confusion matrix membantu kita memahami kelemahan model, yaitu beberapa pasien yang sakit tidak terdeteksi (False Negative). Jika model digunakan untuk situasi kritis seperti diagnosis medis, kita mungkin perlu meningkatkan recall agar tidak ada pasien sakit yang terlewatkan.

Kesimpulan

Confusion matrix adalah tools yang sangat penting untuk mengevaluasi classification model, terutama dalam memahami detail kesalahan prediksi. Dengan menggunakan metrics seperti accuracy, precision, recall, dan F1-score, Kita dapat mengevaluasi kinerja model dengan lebih mendalam dan mengambil langkah perbaikan jika diperlukan.